Apa itu Pipeline?

Sumber: https://www.binar.co.id/blog/data-pipeline-adalah?utm

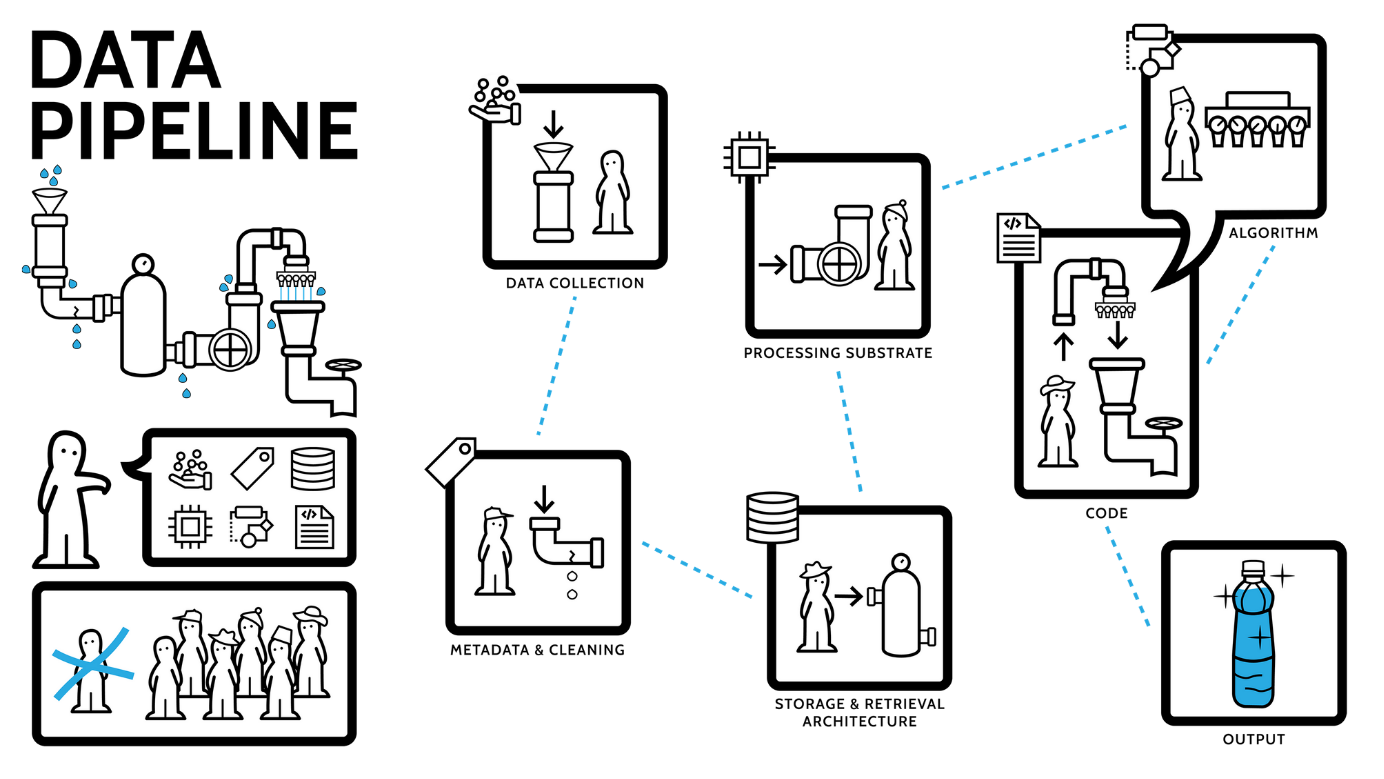

Data pipeline adalah serangkaian proses yang mengumpulkan, memindahkan, memproses, dan menyimpan data dari berbagai sumber ke tujuan akhir, seperti data warehouse atau sistem analitik. Proses ini memungkinkan organisasi untuk mengelola data secara efisien, memastikan data yang dihasilkan akurat dan relevan untuk analisis lebih lanjut.

Sebuah data pipeline yang efektif terdiri dari beberapa komponen kunci:

- Sumber Data (Data Sources): Merupakan titik awal di mana data dikumpulkan. Sumber data dapat berupa sensor IoT, aplikasi, basis data, atau media sosial. Keberagaman sumber ini menyediakan bahan mentah untuk diproses dalam pipeline.

- Pemrosesan Data (Data Processing): Tahap ini melibatkan transformasi data agar sesuai dengan kebutuhan analisis. Proses ini mencakup pembersihan data, normalisasi, dan penggabungan data dari berbagai sumber.

- Penyimpanan Data (Data Storage): Setelah diproses, data disimpan dalam media penyimpanan seperti data warehouse, data lake, atau basis data lainnya yang memudahkan akses dan analisis.

- Orkestrasi dan Pengawasan (Orchestration and Monitoring): Mengelola aliran data melalui berbagai tahap dan memastikan setiap proses berjalan sesuai rencana. Pengawasan juga penting untuk mendeteksi dan menangani kesalahan atau anomali dalam pipeline.

Implementasi data pipeline memberikan berbagai manfaat bagi organisasi:

- Integrasi Data: Menggabungkan data dari berbagai sumber ke dalam satu sistem terpadu, memudahkan analisis dan pelaporan.

- Otomatisasi Proses: Mengurangi intervensi manual dalam pengolahan data, sehingga meningkatkan efisiensi dan mengurangi potensi kesalahan manusia.

- Analisis Real-Time: Memungkinkan pemrosesan data secara real-time, memberikan wawasan yang cepat dan relevan untuk pengambilan keputusan.

- Skalabilitas: Memungkinkan penanganan volume data yang besar dan beragam, sesuai dengan pertumbuhan bisnis dan kebutuhan analisis.

Terdapat beberapa jenis data pipeline, diantaranya:

- Batch Processing Pipeline: Memproses data dalam kelompok pada interval waktu tertentu. Cocok untuk tugas-tugas yang tidak memerlukan hasil instan.

- Streaming Pipeline: Memproses data secara real-time saat data diterima. Ideal untuk aplikasi yang memerlukan respons cepat, seperti deteksi penipuan.

- ETL Pipeline (Extract, Transform, Load): Menarik data dari sumber, mentransformasi sesuai kebutuhan, dan memuatnya ke dalam sistem penyimpanan. Umum digunakan dalam integrasi data tradisional.

- ELT Pipeline (Extract, Load, Transform): Menarik dan memuat data ke dalam penyimpanan terlebih dahulu, kemudian melakukan transformasi. Cocok untuk lingkungan data modern dengan kapasitas penyimpanan dan pemrosesan yang besar.

Sumber: